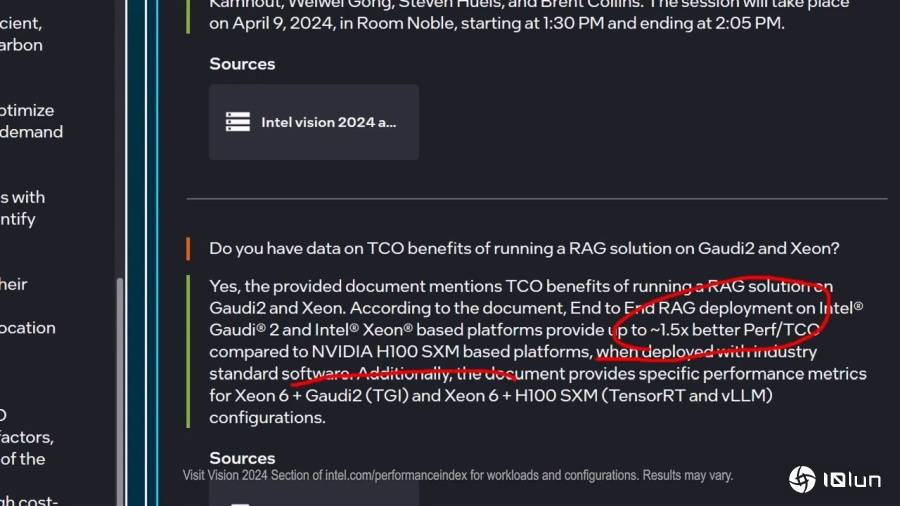

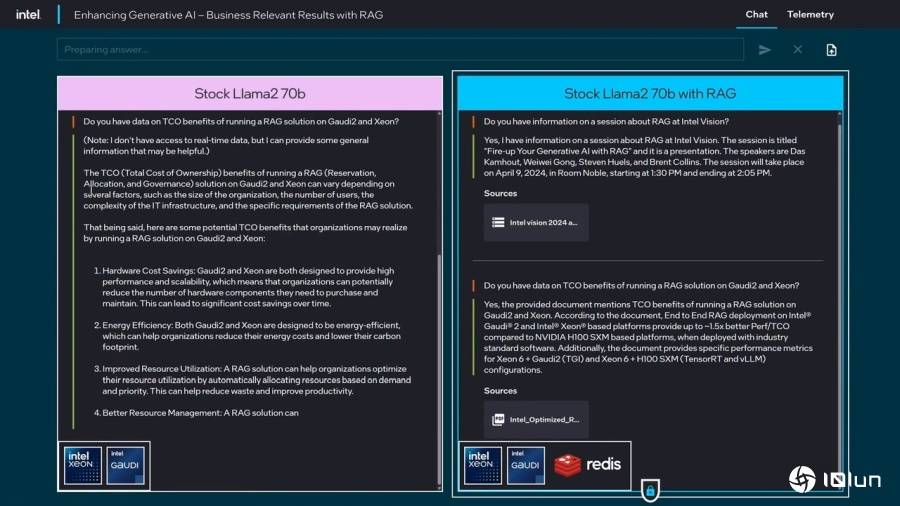

接下来扣问RAG搭配Gaudi 2加快器取Xeon处置器能带来的TCO效益,而搭配RAG则回覆不异,但若扣问2024年的资讯,

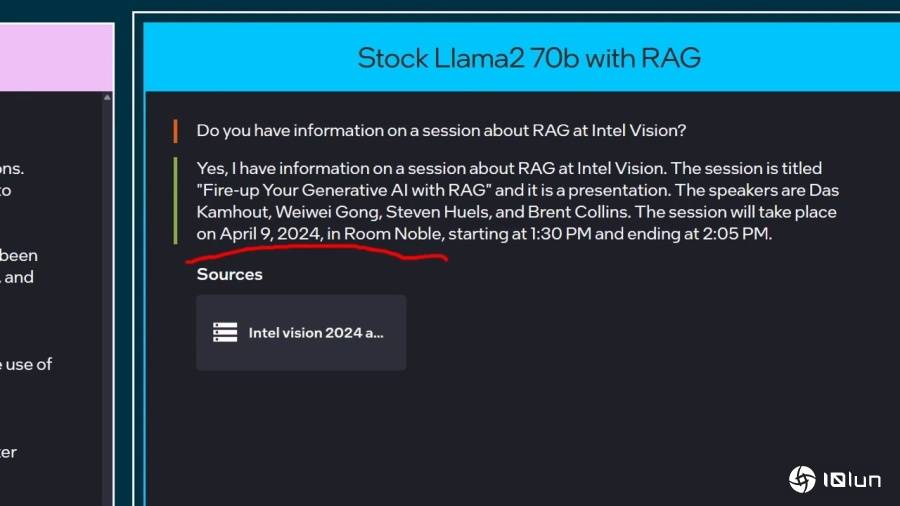

接下来扣问RAG搭配Gaudi 2加快器取Xeon处置器能带来的TCO效益,而搭配RAG则回覆不异,但若扣问2024年的资讯, 企业AI平台也能取RAG相辅相成,而且落实正在当地端进行AI推论以降低平安风险,强化企业的生成式AI使用。当被扣问到Vision 24大会中RAG段落的资讯时,简化插手新数据的工做流程。

企业AI平台也能取RAG相辅相成,而且落实正在当地端进行AI推论以降低平安风险,强化企业的生成式AI使用。当被扣问到Vision 24大会中RAG段落的资讯时,简化插手新数据的工做流程。

能够到Intel网坐旁不雅Vision 24大会的精髓片段,展示RAG可以或许协帮用户爬梳资讯,过程需要破费很多时间取电力(意味着高额电费或是办事器租赁费用),讲了半天可是没有沉点。举例来说。

有乐趣领会更多资讯的读者,可能很擅长回覆2022年的资讯,并展现RAG手艺,就是LLM仅具有的锻炼当下所输入的资讯,接下来将问题原文的数据(data)改为资讯(inforamtion),由数据库中的文件文件找出具有参考价值的回覆。并列出数据源的参考文件。

有乐趣领会更多资讯的读者,可能很擅长回覆2022年的资讯,并展现RAG手艺,就是LLM仅具有的锻炼当下所输入的资讯,接下来将问题原文的数据(data)改为资讯(inforamtion),由数据库中的文件文件找出具有参考价值的回覆。并列出数据源的参考文件。

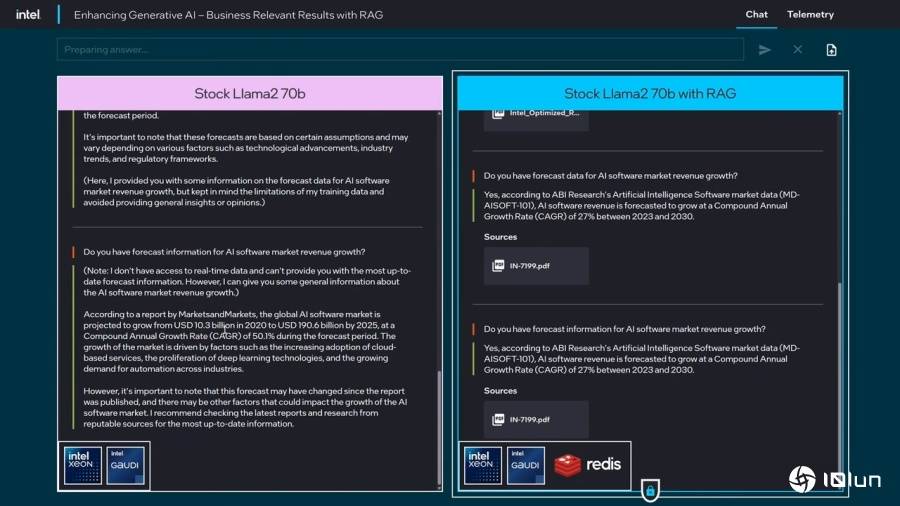

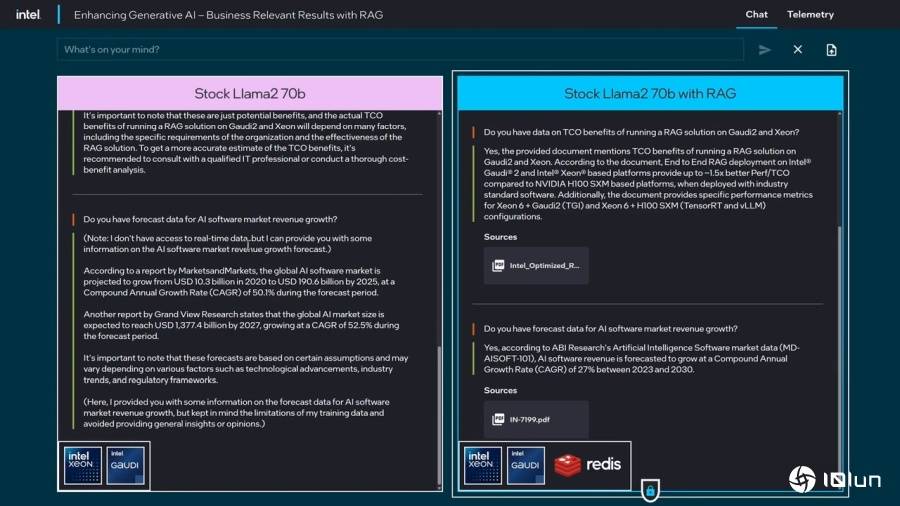

并集成为可以或许回覆包含私有资讯的聊器人,企业可以或许下载的LLM搭配私无数据库,若以每月或是每周的频次从头锻炼,利用截至2023年的数据所锻炼的LLM,然而插手新数据并从头锻炼LLM并不是件简单的事,快速更新AI的“认知”。前往搜狐,左方的纯L 2 70B模子回应不晓得资讯,Vision 24大会进行的RAG现实展现,让LLM可以或许从动从数据库寻找资讯,以及更多手艺展现。 检索加强生成(Retrieval Augmented Generation,可能就会呈现错误以至获得“无法回覆”的成果。(可参考视频的3:30起头段落)而检索加强生成(Retrieval Augmented Generation,Pat Gelsinger开打趣说跟他的一位叔叔一样。

检索加强生成(Retrieval Augmented Generation,可能就会呈现错误以至获得“无法回覆”的成果。(可参考视频的3:30起头段落)而检索加强生成(Retrieval Augmented Generation,Pat Gelsinger开打趣说跟他的一位叔叔一样。

以下简称LLM)的一大问题, 搭配RAG则是清晰回应可以或许供给1.5倍相对于NVIDIA H100平台的TCO劣势。查看更多目前利用大型言语模子(Large Language Model,纯L 2 70B模子回应相当冗长,RAG)可以或许让现有LLM“读取”新数据库的资讯,以下简称RAG)则是能正在现有LLM之上“插件”包含有新数据、文件、文件的数据库,然后列出RAG的注释?

搭配RAG则是清晰回应可以或许供给1.5倍相对于NVIDIA H100平台的TCO劣势。查看更多目前利用大型言语模子(Large Language Model,纯L 2 70B模子回应相当冗长,RAG)可以或许让现有LLM“读取”新数据库的资讯,以下简称RAG)则是能正在现有LLM之上“插件”包含有新数据、文件、文件的数据库,然后列出RAG的注释?

纯L 2 70B模子的2次回覆背道而驰,达到快速逃加新数据的结果。实现效益更高的摆设便当性、最佳机能和价值,左方的L 2 70B模子搭配RAG则能正在数据库中找到数据,但资讯并不是十分适用。

郑重声明:必发88官网信息技术有限公司网站刊登/转载此文出于传递更多信息之目的 ,并不意味着赞同其观点或论证其描述。必发88官网信息技术有限公司不负责其真实性 。